Veracity – Sinnhaftigkeit und Vertrauenswürdigkeit von Big Data als Kernherausforderung im Informationszeitalter

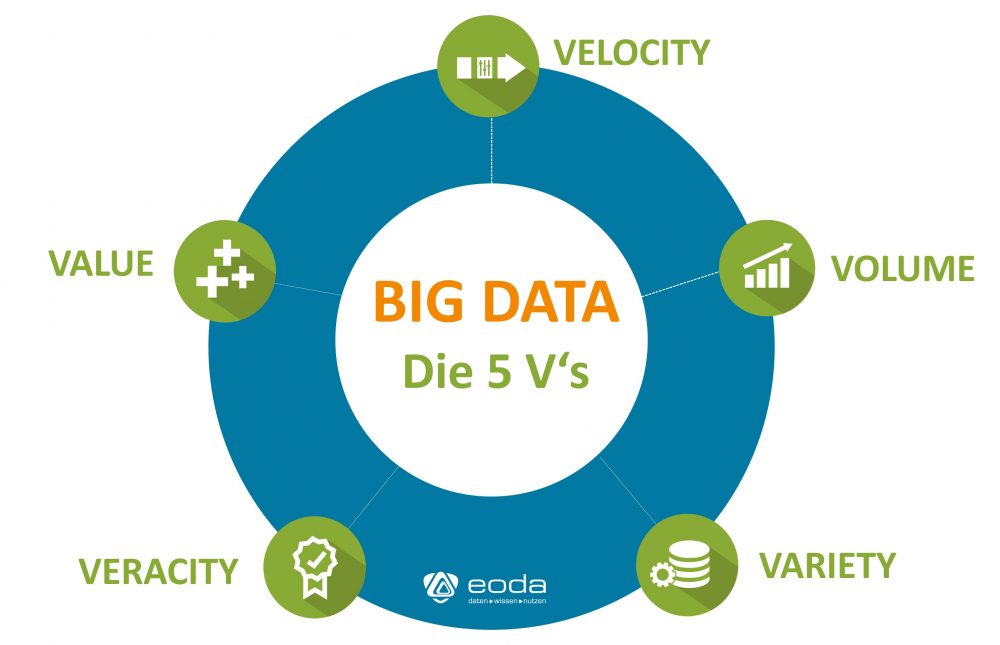

Wer sich intensiver mit Big Data beschäftigt, für den sind die fünf Attribute Volume, Variety und Velocity, Value und Veracity auch bekannt als die „5 V‘s“ oder die „fünf Dimensionen“ von Big Data keine Fremdwörter. Volume, Variety, Velocity, Value und Veracity werden regelmäßig verwendet um die Eigenschaften von Big Data zu charakterisieren und dienen dem Versuch Big Data zu definieren.

Die 5 V’s von Big Data

Die drei zentralen Attribute von Big Data:

- Volume beschreibt dabei das enorme Datenvolumen, das aus dem ständig wachsenden Informationsfluss resultiert. Auch im unternehmerischen Umfeld stehen Entscheider immer häufiger vor der Herausforderung, die Datenmengen effizient und effektiv zu nutzen.

- Velocity bezeichnet die Geschwindigkeit der Datenentstehung und -verarbeitung. Unter anderem durch mobile Internetnutzung und die zunehmende Digitalisierung von z. B. Messergebnissen stehen immer mehr Daten immer schneller zur Verfügung – eine echte Herausforderung für Datenanalysten, vor allem vor dem Hintergrund, dass das Bedürfnis nach sofortiger Informationsextraktion und Verarbeitung der Daten in Echtzeit zunimmt.

- Variety bezieht sich auf die Vielfältigkeit der vorliegenden Datenmenge. Daten können strukturiert, unstrukturiert und semi-strukturiert vorliegen, wobei die Gruppe der semi- und unstrukturierten Daten mit bis zu 85% den größten Anteil ausmacht. Darüber hinaus können Daten in verschiedenen Formaten vorliegen, die nicht ohne Weiteres verglichen werden und auch in weniger griffigen Formaten wie Audio- oder Videodateien vorhanden sein können, deren Extraktion zumeist manuellen Aufwand erfordert.

Im Zeitverlauf sind zwei weitere V’s hinzugekommen:

- Value steht für den Wert, der aus den erschlossenen Daten generiert werden kann. Dieser unterscheidet sich von Branche zu Branche und abhängig vom Anwendungsfall und reicht von der Prognose von Maschinenausfällen bis zur zielgerichteteren Ansprache von Kunden.

- Veracity als Attribut für die Wahrhaftig- oder Sinnhaftigkeit der Daten. Daten entstammen oft unterschiedlichen, Quellen und liegen häufig nur in unzureichender Qualität vor. Hieraus ergeben sich Datenqualitätsprobleme, welche angegangen werden müssen, um Fehlschlüsse aus den Daten zu vermeiden. Im Folgenden stellen wir das Thema Veracity näher vor.

Veracity – blindes Vetrauen oder kritisches Hinterfragen?

Volume, Velocity, Variety: Diesen Kerneigenschaften von Big Data kann mit Hilfe von voranschreitenden Methoden und fortschrittlicher Software zumindest zu einem gewissen Grad begegnet werden, um Value aus den Daten zu generieren. Als Konsequenz, damit dies gelingen kann, schiebt sich die Veracity als Herausforderung immer mehr in den Vordergrund.

Veracity steht für die Sinnhaftigkeit beziehungsweise die Vertrauenswürdigkeit der Daten und der daraus abgeleiteten Ergebnisse, die mitunter zu wünschen übrig lassen kann. Dies zeigt sich beispielswiese darin, dass einer von drei führenden Managern der Datenqualität und den daraus resultierenden Ergebnissen nicht vollends vertraut, wie die Big Data Foundation vor einiger Zeit bekannt gab. In der Regel steht und fällt die Glaubhaftigkeit der Daten und Ergebnisse mit der Qualität der Input-Daten und den gewählten Analysenverfahren.

Datenabfall als Konsequenz unzureichender Glaubhaftigkeit

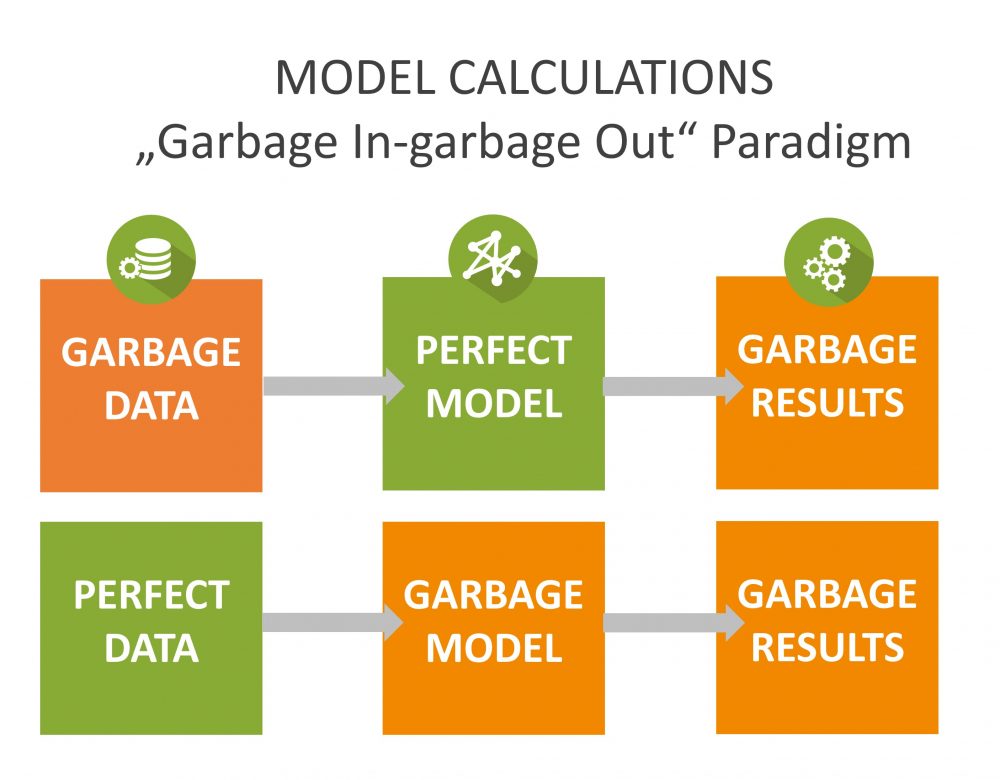

Auf dieses Phänomen bezieht sich das Akronym GIGO, kurz für: „Garbage In – Garbage Out“, das auf das „First In – First Out“-Prinzip der Warenwirtschaft anspielt. Auf die Spitze getrieben wird GIGO zur Abkürzung für „Garbage In – Gospel Out“. Hiermit soll kritisiert werden, dass Ergebnisse, die aus Big Data extrahiert wurden, zu selten hinterfragt und hinreichend überprüft, sondern vielmals als unanfechtbare Wahrheit interpretiert werden. In der folgenden Grafik wird verdeutlicht, dass unzureichend aussagekräftige Ergebnisse sowohl aus qualitativ ungenügendem Input als auch aus unpassenden Modellen resultieren können.

Problematisch kann es vor allem werden, wenn zwar große Datenmengen zur Analyse zur Verfügung stehen, diese jedoch keine hinreichende Aussagekraft bezüglich der Fragestellung beinhalten. Gründe für „Garbage Data“ können zum Beispiel statistische Verzerrungen, Anomalien, Fälschungen, Duplikate oder veraltete Informationen sein.

Dies kann zum Beispiel im Bereich der Instandhaltung, etwa bei industriellen Produktionsanlagen der Fall sein. Werden hierbei Maschinenkomponenten ausgetauscht und die Austauschzeitpunkte für kommende Perioden dokumentiert, können diese Daten nur dann nutzenbringend in Prognoseverfahren eingesetzt werden, sofern auch Informationen über den Zustand der Komponente zum Austauschzeitpunkt vorliegen.

Ansatzpunkte zur Veracity-Steigerung

Anders als bei den drei oben genannten V’s, wie etwa im Hinblick auf das Datenvolumen, wo beispielsweise MapReduce-Algorithmen erfolgreich für ein besseres Handling umfangreicher Datensätze eingesetzt werden können, sind für die Erhöhung der Vertrauenswürdigkeit der Daten bisher keine standardisierten Verfahren verfügbar.

Um valide und vertrauenswürdige Ergebnisse zu erhalten, empfiehlt es sich zudem den gesamten Analyseprozess von der Datenerfassung bis zur Ergebnispräsentation ganzheitlich zu konzipieren. Dabei sollten sowohl die verwendeten Modelle als auch die zum Einsatz kommenden Methoden sorgfältig ausgewählt werden um eine möglichst hohe Sinnhaftigkeit der Ergebnisse zu gewährleisten. Dazu sind allerdings Methodenkenntnisse und Expertise im Bereich der Modellbildung erforderlich, die die Gewinnung von vertrauenswürdigen Daten zu einem Handwerk machen, das ein gewisses Maß an Erfahrung erfordert.

Anmerkung: Dieser Beitrag wurde im Oktober 2020 aktualisiert.

Aus Big Data Mehrwerte generieren

Als Data Science Experten sind wir von eoda Ihr Ansprechpartner, wenn es darum geht aus Daten Value zu generieren, der Sie weiterbringt. Wir begleiten Sie von der Identifikation des richtigen Anwendungsfalls, über das Datenmanagement und die Modellbildung bis zur Implementierung des Analysemodells in Ihre Geschäftsprozesse.

Erfahren Sie mehr darüber, wie wir von eoda Sie dabei unterstützen können.