Wie kann die Zukunft der Markenprüfung mithilfe von KI und LLMs aussehen?

Innovatives Projekt am Eidgenössischen Institut für Geistiges Eigentum (IGE|IPI)

Rahmenbedingungen

Komplexer, mehrstufiger Prüfungsprozess mit unterschiedlichen Informationsquellen

Ziel

Zeitersparnis beim Prüfungsprozess von zu schützenden Marken

Lösung

RAG-basiertes Assistenzsystem, das die Entscheidungsfindung durch Auffinden relevanter Informationen unterstützt.

Ausgangssituation

Das Eidgenössische Institut für Geistiges Eigentum (IGE|IPI) ist die zentrale Schweizer Bundesstelle für Patente, Marken, Designschutz, geschützte geografische Angaben und Urheberrecht. Die Mitarbeitenden gewährleisten täglich die korrekte Eintragung und Sicherung von Markenrechten.

Dieser mehrstufige, äußerst komplexe Prüfvorgang umfasst eine Vielzahl von Schritten und entscheidet darüber, ob eine Marke oder ihre Bestandteile bereits geschützt oder schützenswert sind. Dafür stehen den Mitarbeiterinnen und Mitarbeitern unzählige Dokumente zur Verfügung (z. B. Nizza-Klassifikation, Internationale Abkommen etc.).

Die einzelnen Informationsquellen haben dabei unterschiedliche Gewichtungen für die Entscheidungsfindung. So sind beispielsweise internationale Abkommen und Gesetze höher zu bewerten als Referenzfälle zu einzelnen Markenansprüchen. Die Prüfung erfolgt mittels einer eigenen Software, in der alle Dokumente der Prüfungshilfe durchsuchbar sind. Der Prozess einer Markenprüfung kann – je nach Erfahrung und Rahmenbedingungen – sehr zeitaufwändig sein, da alle relevanten Informationen recherchiert und zusammengetragen werden müssen.

Ziel

Das IGE hat sich an eoda gewandt, um ein innovatives Pilotprojekt zu starten: Ein RAG-basiertes KI-Assistenzsystem in der Prüfungshilfe im Markenschutz.

Das IGE hat das Ziel, den komplexen Prüfprozess zu vereinfachen und die Fachabteilung zu entlasten. Neben der automatisierten Unterstützung möchte das IGE das Pilotprojekt nutzen, um Erfahrungen im Umgang mit KI-Systemen zu sammeln bzw. die technische Machbarkeit für die eigenen Anwendungsfälle mit diesem Projekt zu prüfen.

RAG (Retrieval-Augmented Generation) ist eine Methode, um die Qualität von Sprachmodellantworten zu verbessern. Anstatt sich ausschließlich auf seine Trainingsdaten zu verlassen, zieht RAG externe, aktuelle Informationen heran. Dabei werden relevante Datenquellen durchsucht (Retrieval) und der Prompt mit den gefundenen Informationen erweitert (Augmentation). Dies ermöglicht dem Modell, fundierte und aktuelle Antworten zu generieren (Generation) und sogenannte „Halluzinationen“ (frei erfundene Falschinformationen) zu vermeiden.

Welche Vorteile bietet dieser Ansatz beim Einsatz von Sprachmodellen im Unternehmenskontext?

Herausforderung

Neben der Komplexität des Prüfprozesses sind auch die Aspekte der Datensicherheit und des Schutzes geistigen Eigentums zu beachten: Die Datengrundlage des IGE enthält sensible Informationen, weswegen eine Umsetzung „On-Premise“ präferiert wurde, sodass keine Daten extern geteilt werden. Die lokale Ausführung stellt besondere Anforderungen an die eingesetzten Sprachmodelle, da die verfügbare GPU-Leistung vor Ort ein limitierender Faktor ist.

Lösung

Bei der bisherigen Prüfung, ob eine Marke geschützt werden kann, muss der zu schützende Begriff aufwändig hinsichtlich der oben genannten Dokumente geprüft werden. Dazu müssen die PrüferInnen den Begriff und relevante Teilbegriffe mit ähnlichen Begriffen vergleichen. Zusätzlich gilt es, den Begriff bezüglich geografischer Angaben, geltenden Gesetzen & Abkommen oder etwa bereits ähnlich getroffener Entscheidungen zu prüfen – wobei immer auch die Ähnlichkeit der relevanten Nizza-Klassifikationen (z.B. Klasse 30: „Kaffee, Tee, Kakao, Reis, Gewürze“) zu berücksichtigen ist. Dies alles geschieht durch die manuelle Auswahl der jeweiligen Quellen.

Im Rahmen des Projektes hat eoda eine lokale RAG-Pipeline inklusive grafischer Oberfläche zur einfachen Abfrage der für die Entscheidungsfindung wichtigen Dokumente entwickelt.

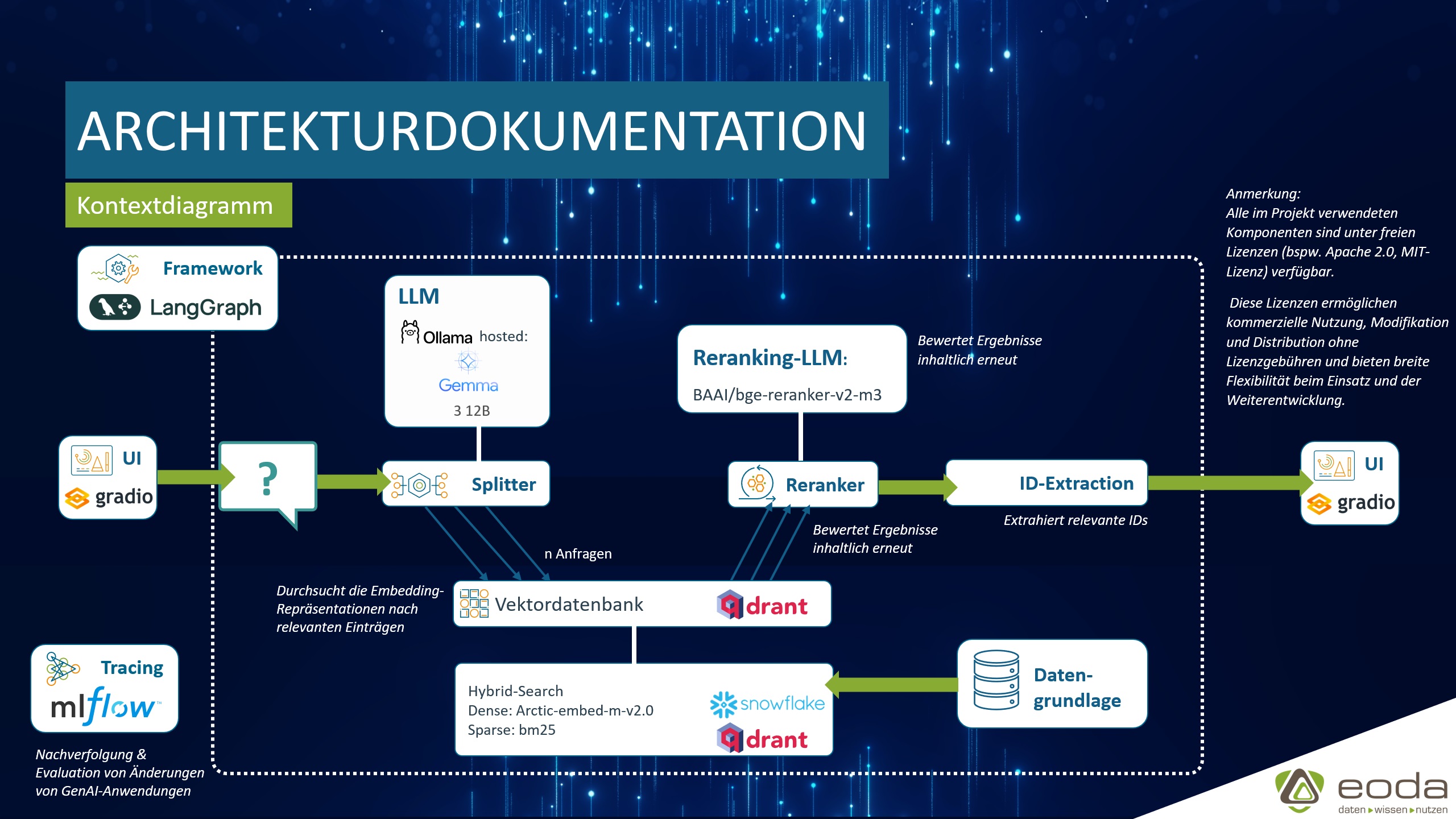

Nach der Eingabe des Suchbegriffs (zu prüfende Marke) wird dieser durch ein Sprachmodell aufgeteilt. Sowohl die einzelnen Wortbestandteile als auch der vollständige Begriff werden an eine Vektordatenbank weitergeleitet und mittels hybrider Suche geprüft. Die Vektordatenbank enthält dabei die Datengrundlage, also die oben genannten Dokumente. Die Ergebnisse (IDs der Dokumente) der hybriden Suche werden anschließend über ein weiteres Sprachmodell nach ihrer Relevanz für die Entscheidung sortiert und gefiltert (Reranking). Ein wesentlicher Bestandteil komplexer Projekte ist die passende Zusammenstellung der Systemkomponenten, um ein ideales Verhältnis zwischen Performance (z.B. Reaktionsgeschwindigkeit) und Ergebnisqualität zu erhalten.

Unsere über 15 Jahre Praxiserfahrung zeigen, dass ein iterativer, agiler Ansatz bei komplexen Anwendungsfällen am erfolgversprechendsten ist, da kein universelles Set an Komponenten existiert, das in jeder Konfiguration für jeden Anwendungsfall zuverlässig optimale Ergebnisse liefert. Vielmehr erfordert jeder Anwendungsfall eine individuelle Feinabstimmung und Auswahl der am besten geeigneten Bausteine. Durch die agile Anpassung und fortlaufende Identifizierung der geeignetsten Systemkomponenten (LLM, Vektordatenbank, alternative Schritte, Prompts etc.) lassen sich selbst bei On-Premise-Umsetzungen stets die bestmögliche Kombination finden. Alle im Projekt verwendeten Komponenten sind unter freien Lizenzen (bspw. Apache 2.0, MIT-Lizenz) verfügbar. Diese Lizenzen ermöglichen kommerzielle Nutzung, Modifikation und Distribution ohne Lizenzgebühren und bieten eine breite Flexibilität beim Einsatz und der Weiterentwicklung und mit Blick auf Abhängigkeiten gegenüber kommerziellen Anbietern.

Eine technisch tiefergehende Betrachtung der eingesetzten Komponenten des Projekts finden Sie in unserem Blog

Ergebnis

Bereits kurz nach Projektbeginn kann das Assistenzsystem belastbare Ergebnisse liefern, die sowohl die technische Machbarkeit als auch die Eignung des Anwendungsfalls „Markenprüfung“ für den Einsatz künstlicher Intelligenz bestätigten.

Dieses KI-Projekt für das IGE zeigt, welches große Potenzial KI als Unterstützung für die ExpertInnen hat – auch in einem hochkomplexen und sensiblen Umfeld wie der Markenprüfung. Der Schlüssel liegt dabei in der sinnvollen Verbindung aus verlässlicher KI-basierter Automatisierung von aufwändigen Routineprozessen und der menschlichen Expertise.

Welche Aufgabe hat eine Vektordatenbank?

Was ist ein Embedding-Modell? Eine Erklärung zu Bausteinen einer RAG-Pipeline finden Sie in unserem Blog-Beitrag.

Insgesamt trägt das Projekt wesentlich dazu bei, das Vertrauen in die Technologie zu stärken, interne Stakeholder zu überzeugen und die strategische Relevanz des KI-Einsatzes im Unternehmen zu untermauern. Dies stellt einen wichtigen Meilenstein für den nachhaltigen Projekterfolg dar.

* Bildquelle: Eidgenössisches Institut für Geistiges Eigentum IGE|IPI

„Dieses Projekt markiert einen bedeutenden Fortschritt für uns. Die Zusammenarbeit mit eoda war von echtem Teamgeist, technischem Verständnis und Eigeninitiative geprägt. Wir haben uns und unseren Anwendungsfall von Beginn an verstanden gefühlt. Dank des Projekts und eoda haben wir wertvolle Erfahrungen für den zukünftigen Einsatz Künstlicher Intelligenz gesammelt, ein tieferes Verständnis für unsere Datenbasis entwickelt und freuen uns auf die Zukunft.“

Susanne Wenger | Projektleitung & Fachverantwortliche ICT-Architektur| Eidgenössisches Institut für Geistiges Eigentum IGE|IPI