Ihr habt den besten Job des 21. Jahrhunderts, seid die Goldschürfer im Big-Data-Zeitalter, die Segler auf dem Datenmeer – kurzum: In vielen Unternehmen seid ihr die digitalen Möglichmacher. Ausgestattet mit Skills, die euch gefühlt zu den Universalgelehrten der Moderne machen und einem Toolset, das so umfangreich und komplex ist, dass selbst Astronauten schwindelig werden kann.

Aber da ist noch etwas, was euch jeden Tag bei der Arbeit begleitet: Ein großer Rucksack voller Erwartungen und Anforderungen von Kollegen, Vorgesetzten oder Kunden. Data Scientist ist ein Traumjob, aber eben auch ein verdammt stressiger, der jeden Tag kreative Ansätze und neue Lösungen erfordert.

Da wäre es doch schön, wenn es etwas gäbe, das euch den Arbeitsalltag erleichtern könnte.

Viele Anforderungen, eure Sehnsucht nach einer Lösung

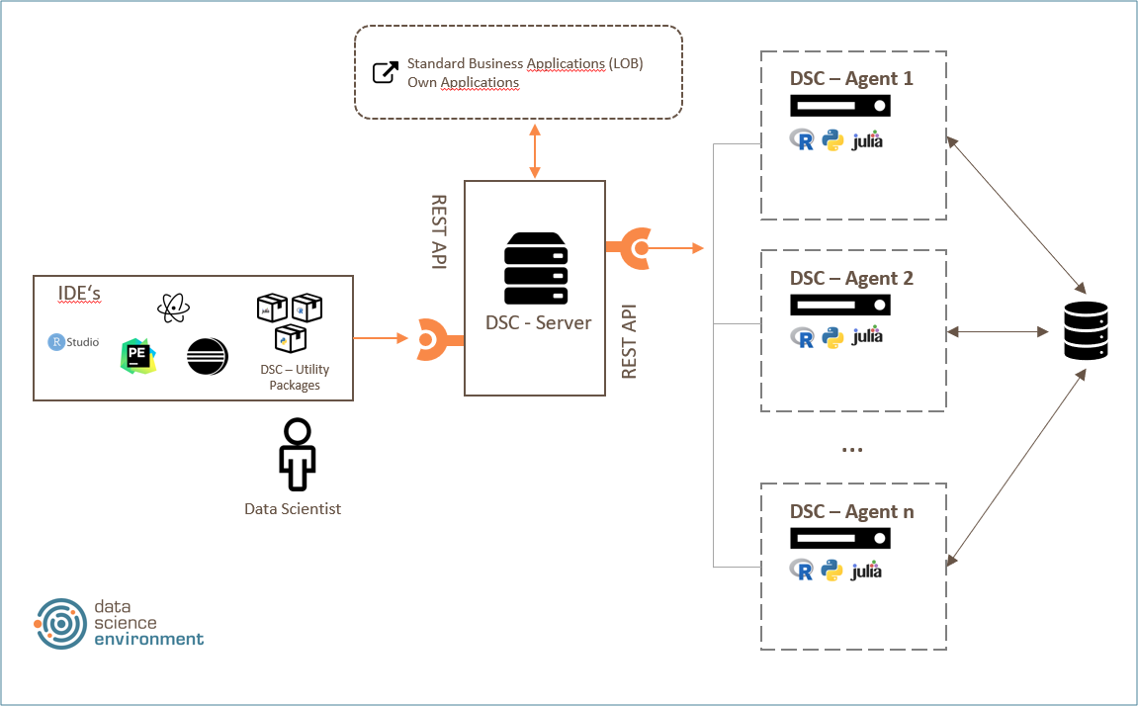

R, Python oder Julia: Eure Abteilung arbeitet mit mehreren Analysesprachen? Da wäre es doch gut, eine Lösung zu haben, welche die Arbeit mit mehreren Sprachen optimal unterstützt und damit das fördert, was bei der Datenanalyse so essentiell ist: die Zusammenarbeit im Team. Darüber hinaus könnten euch Connectivity Pakete ermöglichen, eure Arbeit in einer gewohnten Umgebung wie RStudio oder der von euch gewünschten IDE ausführen zu können.

Performance is everything: Ihr spannt die komplexesten neuronalen Netze und verarbeitet Datenmengen, die den Zusatz „Big“ wirklich verdienen. Stellt euch vor, ihr könntet eure Analysen in eine kontrollierte und skalierbare Umgebung überführen, in der eure Skripte nicht nur zuverlässig, sondern auch bei einer optimalen Lastverteilung ausgeführt werden können – inklusive horizontaler Skalierung und Steigerung der System-Performance.

Datenquellen, Nutzer und Analyseskripte: Gäbe es doch ein Tool, das alle Komponenten in einem Analyseprojekt zusammenbringt, sie verwaltet und damit das Fehlerpotenzial minimiert und die Nachvollziehbarkeit erhöht. Am besten mit einer Rollenverwaltung, die auch bequem auf die Fachabteilungen ausgeweitet werden kann.

Zeit ist Gold: Das gilt natürlich auch für eure Arbeitszeit. Eine Lösung zur Überwachung und Parametrisierung der Skriptausführung sowie zur automatischen Ausführung von Analysen könnte euch von zeitfressenden Routineaufgaben befreien. Zusätzlich stellen die dynamische Lastverteilung und das Logging der Skriptausgaben die Operationalisierung der Skript-Ausführung im unternehmenskritischen Umfeld sicher.

Das Drumherum stets im Blick: Eure performanteste Analyse bringt euch natürlich nicht die verdiente Anerkennung, wenn ihr sie nicht optimal in die bestehende IT-Landschaft einbinden könnt. Da wäre es doch perfekt, wenn das Tool, welches euch die tägliche Arbeit erleichtert auch noch über konsistente Schnittstellen verfügt, um eure Analyseskripte per REST-API nahtlos in jede bestehende Anwendung zu integrieren.

eoda | data science core: Eine Lösung von Data Scientists – für Data Scientists

Stell dir ein Data Science Tool vor, was dir dabei hilft dein Analytik-Potenzial zu entfachen mit dem du in der unternehmerischen Welt profitierst.

Auf Basis jahrelanger Erfahrungen aus Analyseprojekten und mit dem Wissen über eure täglichen Herausforderungen, haben wir von eoda eine Lösung für euch geschaffen: Den eoda | data science core. Steuert mit dem data science core eure Analyseprojekte flexibel, performant und sicher und schafft euch die Freiräume, die ihr braucht, um den Rucksack der Erwartungen über den nächsten Berg zu tragen und die euch dabei helfen, nie die Freude an eurem Beruf zu verlieren – es ist schließlich der sexieste der Welt.

Die Umgebung des eoda | data science bietet einen Rahmen für die Erstellung und Verwaltung unterschiedlicher Container mit mehreren Setups für unterschiedliche Anwendungen.

Um das eoda | data science environment zu vervollständigen, wird der eoda | data science core durch das eoda | data science portal ergänzt. Wie euch das Portal kollaborative Zusammenarbeit, explorative Analysen und eine benutzerfreundliche Visualisierung der Ergebnisse ermöglichen kann, erfahrt ihr im nächsten Artikel.

Hier entlang.