Mit knapp 100 Teilnehmerinnen und Teilnehmern war die Veranstaltung von Beckhoff zum Thema „Maschinelles Lernen in der Automation“ ein voller Erfolg. Während des zweitätigen Webinars erhielten die Teilnehmer von Dr. Fabian Bause, Produktmanager TwinCAT von Beckhoff, und Oliver Bracht, Chief Data Scientist und Geschäftsführer von eoda, Einblicke in datenbasierte Lösungswege.

Themen des Webinars

- Predictive Maintenance

- Kollaborative und kontextbewusste Robotik

- Ausschussreduktion

- Automatisierte Qualitätskontrolle

- Maschinenoptimierung

- Einführung Machine Learning

- Zusammenspiel Domänenexperten und Data Scientists

- Werkzeuge & Tools

- Zusammenspiel Data-Science-Plattform und TwinCAT

- Anomaly Detection, der Prozess

Tag 1 – Anwendungsbeispiele und der Weg zum erfolgreichen KI-Projekt

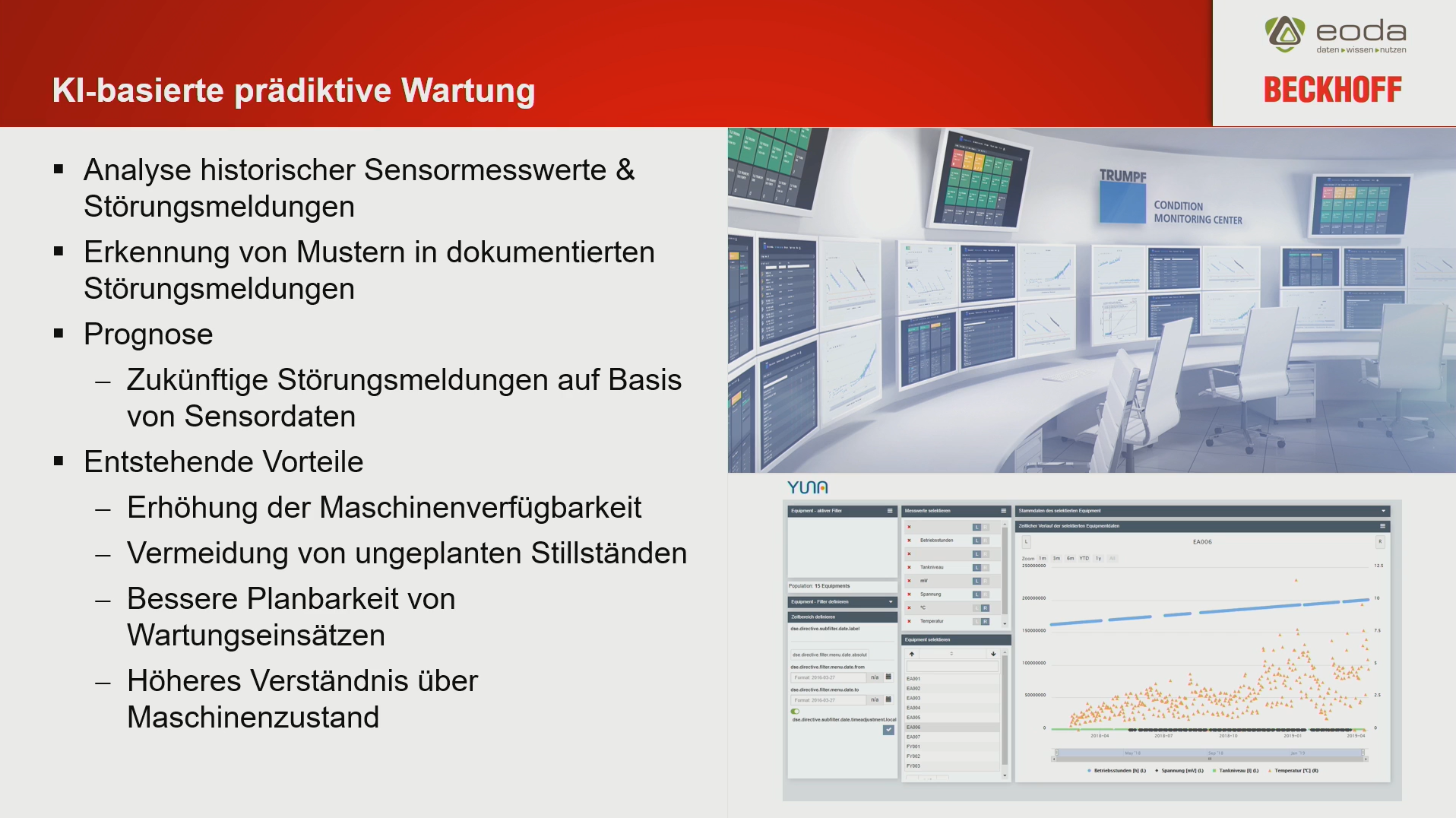

Predictive Maintenance

Bei der vorausschauenden Wartung geht es im Kern darum, die Maschinenverfügbarkeit zu erhöhen, die Kosten für die Sicherstellung der Produktionsqualität sowie Instandhaltung zu senken. Dadurch steigt wiederum die Wirtschaftlichkeit der einzelnen Maschinen. Auch können sich hierdurch neue Geschäftsfelder für Maschinenbauer entwickeln, z.B. durch einen proaktiven Support.

Predictive Maintenance ist die konsequente Weiterentwicklung des Condition Monitorings, bei dem Maschinenzustände anhand verschiedener Werte kontrolliert werden.

Predictive Maintenance geht einen Schritt weiter: Basierend auf historischen Sensordaten lassen sich Machine-Learning-Modelle trainieren, die anschließend Anomalien vorhersagen. Anomalien können dabei auf fehlerhafte Komponenten deuten, die ausgetauscht werden müssen oder aber Betriebsmittel, die während des Prozesses verbraucht werden, sich aber einem direkten Monitoring entziehen. Diese Vorhersagen können dann genutzt werden, um beispielsweise Wartungseinsätze im Vorfeld zu planen, damit Komponenten ausgetauscht werden, bevor ein möglicher Verschleiß den Stillstand der Maschine bedeuten würde

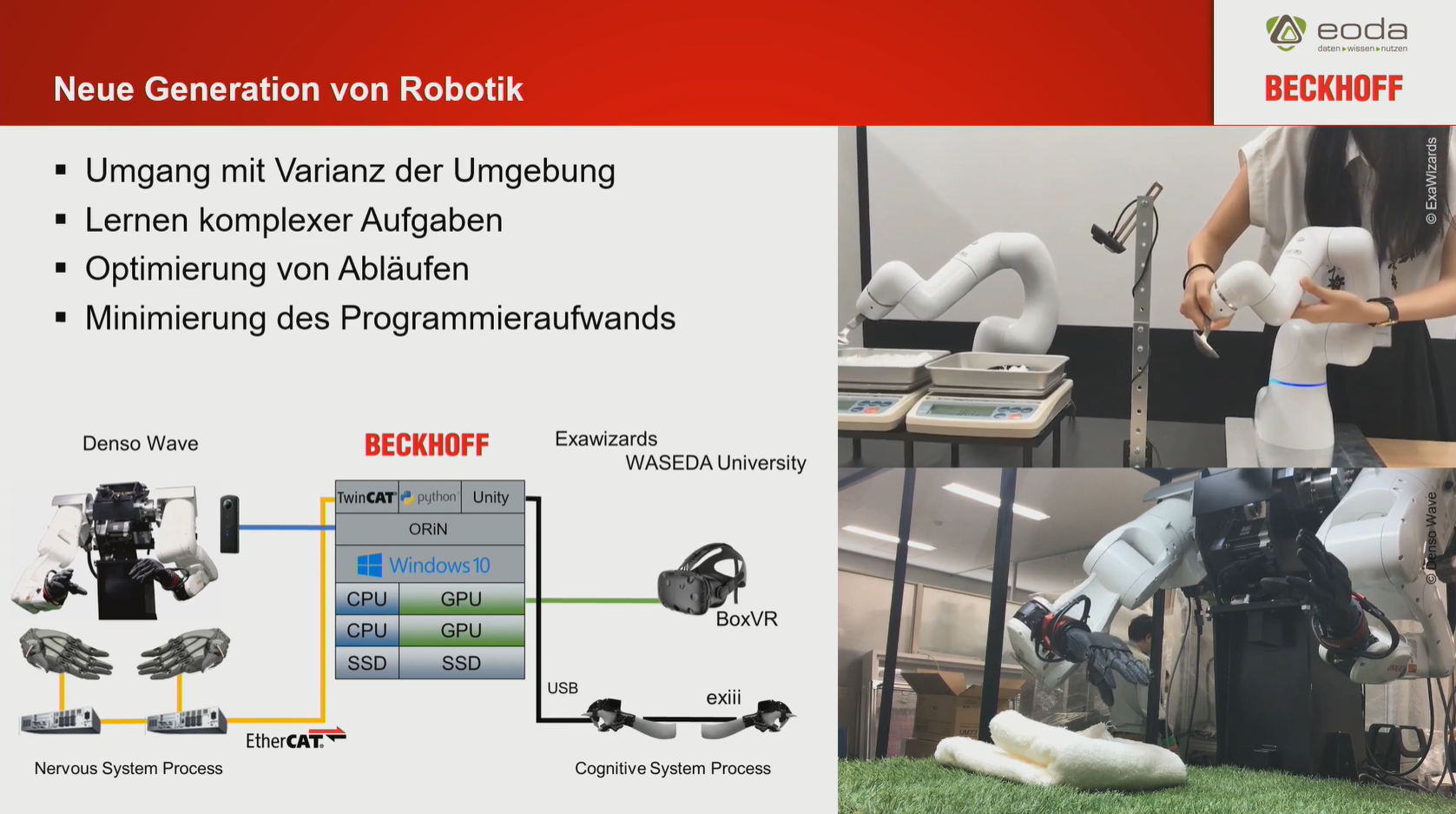

Kollaborative und kontextbewusste Robotik

Hierbei „imitieren“ Roboter das menschliche Lernen. Beim gezeigten Beispiel wurden Roboter mithilfe von Beckhoff’s TwinCAT angelernt. Dabei wurde gezeigt, wie Roboter z.B. per Virtual Reality oder manuell, bestimmte Abläufe übernehmen, indem sie die Bewegungen nachempfinden, die der Mensch durchführt. Diese Bewegungen können dann von Algorithmen analysiert und entsprechend angepasst werden.

Der Vorteil: Im Gegensatz zu einer aufwändigen Programmierung der Abläufe, welche oft nur bestimmte Variablen abdecken, kann die KI das Gelernte auch in anderen Umgebungen durchführen. Dadurch sinkt die Entwicklungszeit drastisch und die Qualität der Prozesse steigt (insbesondere bei komplexen Abläufen).

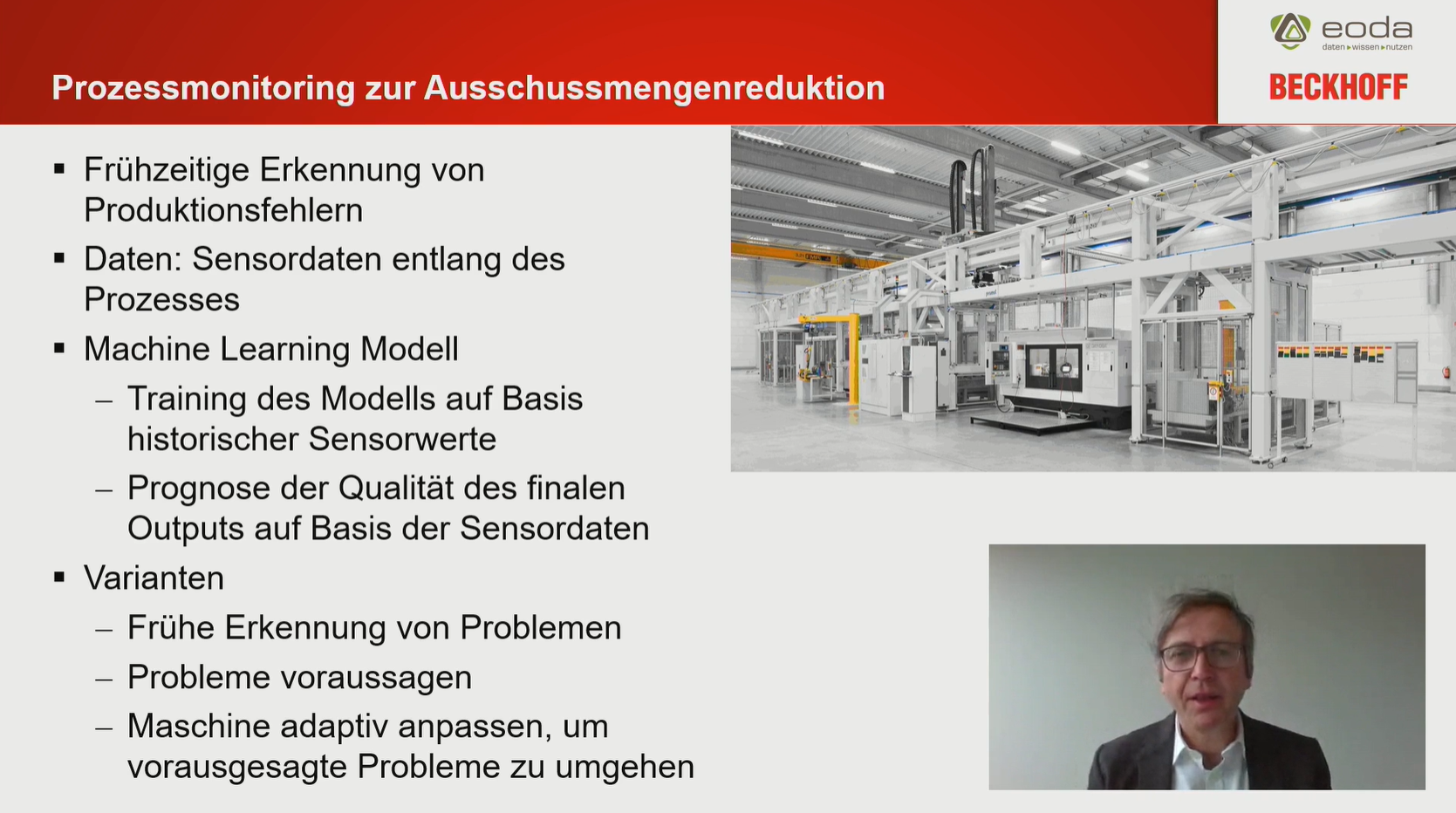

Ausschussreduktion

Ziel ist es die Qualitätssicherung signifikant zu steigern und gleichzeitig die Kosten durch eventuelle fehlerhafte Komponenten zu senken. Durch die Analyse von Sensordaten entlang eines Produktionsprozesses, lassen sich frühzeitig Fehler erkennen. Dies ist besonders dort wichtig, wenn Werkstücke im Laufe des Prozesses verändert werden. Auch hier werden zunächst historische Daten analysiert, um einen Algorithmus zu trainieren. Dieser überwacht dann den Fertigungsprozess durch die verschiedenen Sensoren und kann so Abweichungen nicht nur erkennen, sondern ebenfalls vorhersagen. Anschließend kann die Vorhersage genutzt werden, um die Maschinenparameter entsprechend anzupassen. Bei der Ausschlussreduktion können die Grenzen hinzu Predictive Maintenance verschwimmen.

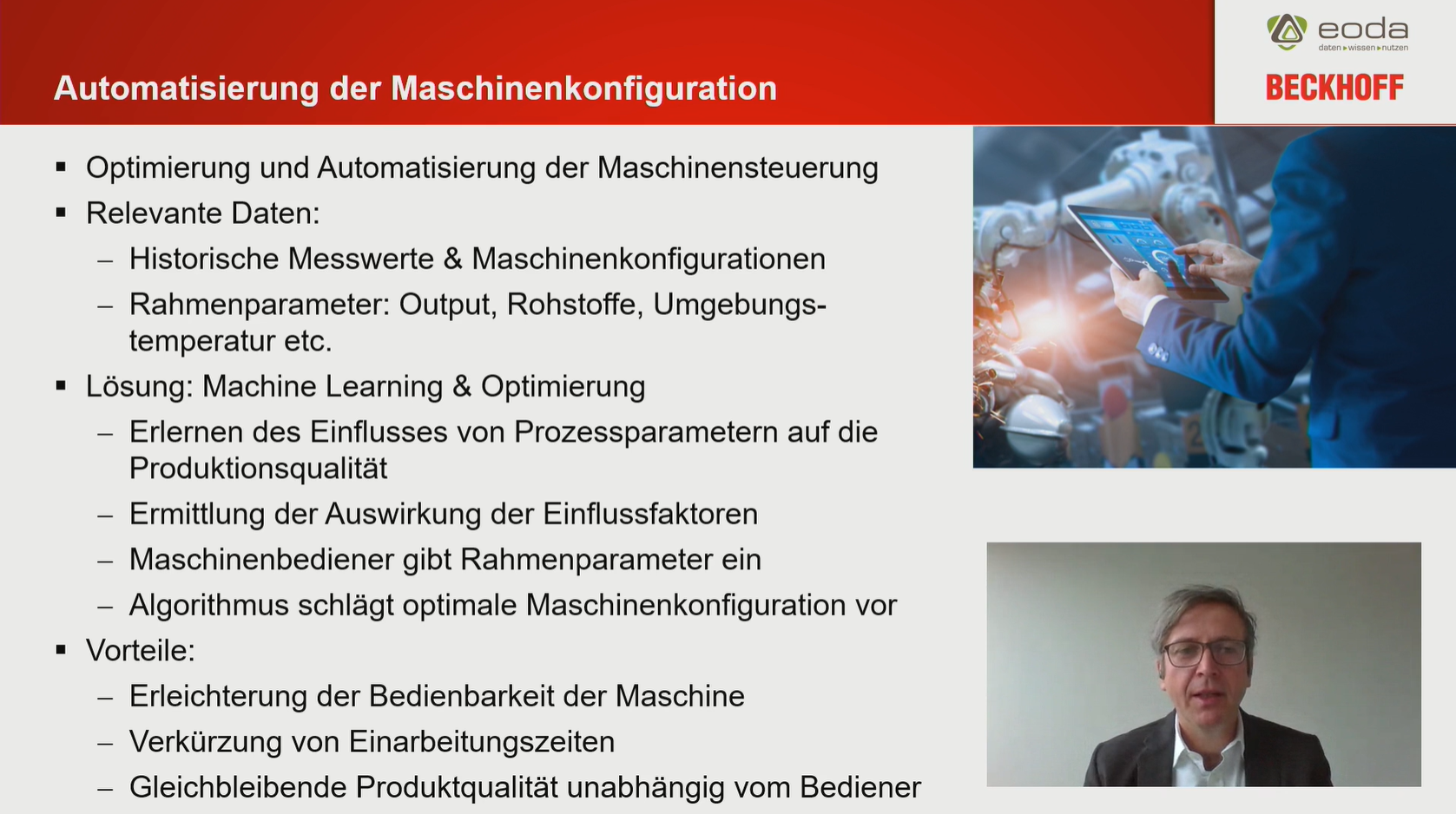

Maschinenoptimierung

Ziel ist es bei gleichbleibender Produktqualität die Bedienbarkeit von Maschinen zu erleichtern, um so u.a. die Einarbeitungszeiten zu verkürzen.

Nach dem Erlernen des Produktionsprozesses, schlägt der Algorithmus eine optimale Maschinenkonfiguration vor, die der Anwender nutzen kann.

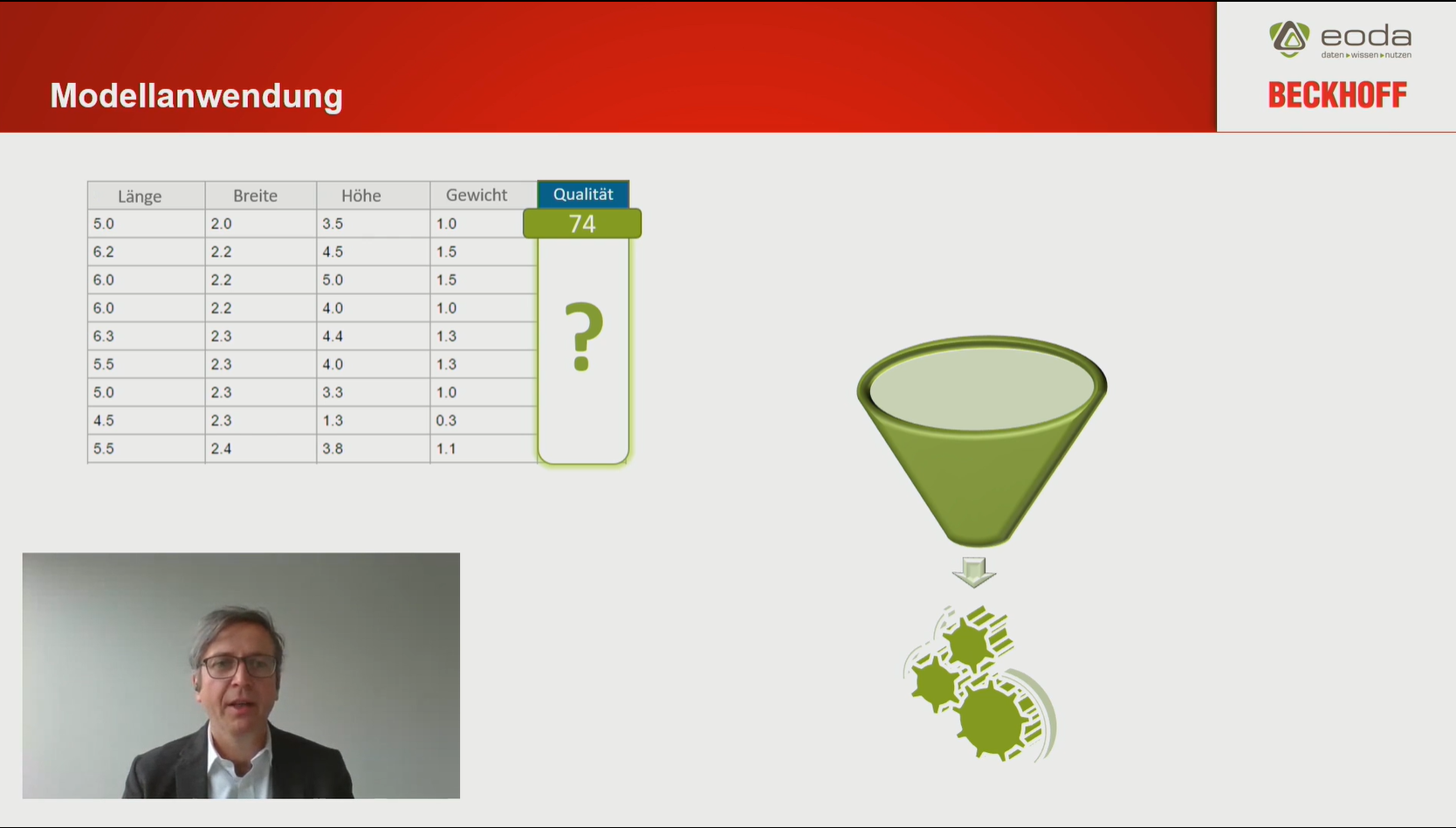

Einführung Machine Learning

In diesem Kapitel ging es thematisch tiefer in unser Kerngeschäft. Hier wurden u.a. verschiedene Ansätze, Methoden und Techniken näher erläutert.

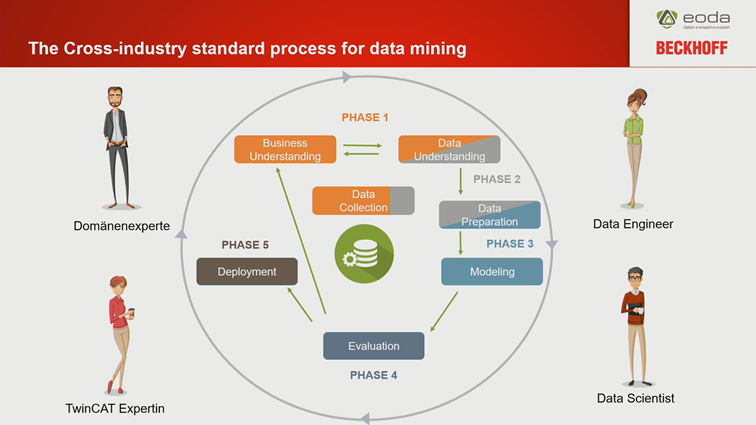

Zusammenspiel Domänenexperten und Data Scientists

Bei einem Data-Science-Projekt sind verschiedene Mitglieder immens wichtig.

Es muss ein Zusammenspiel aus dem fachlichen und wirtschaftlichen Know-How der Domänenexperten und der „technischen“ Experten stattfinden. Nur durch die Kombination von Datenerfassung, Validierung, Exploration und Bereitstellung können Modelle entstehen, die den Domänenexperten und den Unternehmen einen wirklichen Mehrwert liefern.

Für eine schnelle Realisierung von Data-Science-Projekten, wendet eoda ein spezielles Format an: Der Data Science Design Sprint. In einem kompakten Prozess von ca. 7-10 Tagen werden Lösungswege entwickelt an deren Ende ein Prototyp eines realen digitalen Service entsteht.

Werkzeuge & Tools

TwinCAT

Nicht nur das Umfeld der Algorithmen wird immer komplexer – die Maschinen selbst werden im Aufbau, Funktion und Wartung immer komplexer. Um den Engineering-Aufwand zu reduzieren bietet Beckhoff eine umfassende und modulare Steuerungssoftware zur Automatisierung an: TwinCAT ist mittlerweile ein globaler Standard. Im Zusammenhang mit einem Data-Science-Projekt kann TwinCAT genutzt werden, um die Datenerfassung zu automatisieren (externer Link). So ist es möglich die Datenaufzeichnung aus der PLC anzustoßen. Dadurch lassen sich auch prozessgesteuerte Aufzeichnungen realisieren.

Data-Science-Plattform

Damit datenbasierte Services den größtmöglichen Impact in Unternehmen haben, braucht es eine skalierfähige Plattform, die nicht nur den bloßen Prozess abdeckt. Mit einer Plattform ebnen wir den Weg für Domänenexperten hinzu Citizen Data Scientist, um die Time-to-Insight und Time-to-Market digitaler Services signifikant zu verkürzen.

Individuelle Dashboards sowie Funktionen, um eigene Analyseideen Realität werden zu lassen, kombiniert YUNA mit umfassenden Integrationsmöglichkeiten.

Die so gewonnen Informationen lassen sich dann in YUNA nutzen, um diese für die Domänenexperten zu visualisieren und an Data Scientists zur Modellentwicklung weiterzugeben.

Tag 2 – Werkzeuge und Umsetzung eines KI-Projektes, Systemarchitektur und Best Practice

Tag 2 – Werkzeuge und Umsetzung eines KI-Projektes, Systemarchitektur und Best Practice

Der zweite Tag stand ganz im Zeichnen von praktischen Hands-On. In Live-Demos wurde gezeigt, wie Datenerfassung durch TwinCAT während des Prozesses geschieht. Darauf aufbauend wird gezeigt wie in eine Data-Science-Plattform per Result Rating die Analyse optimiert werden kann.

Zusammenspiel Plattform und TwinCAT

Um Daten möglichst schnell aus der Steuerung auszulesen wurden zunächst die Möglichkeiten von TwinCAT gezeigt. Hier wurden zwei Lüfter kontrolliert und der Datenstrom in TwinCAT eingelesen und zur weiteren Analyse vorbereitet.

In diesem Zusammenhang werden die durch TwinCAT aufgezeichneten Daten in der Plattform für die Domänenexperten visualisiert, um eventuelle Anomalien erkennen.

Hierbei werden die Ergebnisse des Algorithmus durch die Domänenexperten per Tastendruck bewertet – d.h. ob es sich tatsächlich um eine Anomalie handelt oder ob dieser Wert unproblematisch für den weiteren Prozess ist. Die Ergebnisse der Bewertungen werden dann direkt den Data Scientists zugespielt, um den Algorithmus entsprechend anzupassen. Möglich macht dies das Result Rating in der Plattform.

Dieser sonst so aufwändige Schritt, zwischen initialer Anomalieerkennung und Anpassung war in der Vergangenheit sehr zeitraubend – es mussten mitunter Screenshots ausgetauscht werden, Meeting anberaumt werden etc. Mehr noch: Auf die gleiche Weise bietet die Plattform die Möglichkeit „unlabeled data“ in „labeled data“ zu transformieren, die als initialer Trainigsdatensatz für Algorithmen genutzt werden können. Nun wird dieser Schritt zeitlich drastisch gekürzt.

Anomaly Detection: der Prozess

Um in der Lage zu sein, Anomalien im Maschinenumfeld zu erkennen, braucht es verlässliche Trainingsdatensätze – also verlässliche Informationen, ob es sich um eine Anomalie handelt oder nicht. Die beste Lösung hier ist das Zusammenwirken von Domänenexperten und Data Scientists.

Unsupervised Learning:

Es ist nicht bekannt, inwiefern sich die Datenpunkte unterscheiden (unlabeled data) z.B. Sensordaten

Supvervised Learning:

Es braucht klassifzierte Daten (labeled data), nun muss der „Grenzwert“ gefunden werden, der sie voneinander unterscheidet.

Über Beckhoff

Beckhoff realisiert offene Automatisierungssysteme auf der Grundlage PC-basierter Steuerungstechnik. Das Produktspektrum umfasst die Hauptbereiche Industrie-PC, I/O- und Feldbuskomponenten, Antriebstechnik und Automatisierungssoftware. Für alle Bereiche stehen Produktlinien zur Verfügung, die als Einzelkomponenten oder im Verbund als ein vollständiges, aufeinander abgestimmtes Steuerungssystem fungieren. Beckhoffs New Automation Technology steht für universelle und branchenunabhängige Steuerungs- und Automatisierungslösungen, die weltweit in den verschiedensten Anwendungen – von der CNC-gesteuerten Werkzeugmaschine bis zur intelligenten Gebäudesteuerung – zum Einsatz kommen.

Website: https://www.beckhoff.com/de-de/

Veröffentlicht: 19. März 2021

AutorIn

Starten Sie jetzt durch:

Wir freuen uns auf den Austausch mit Ihnen.